AI行业资讯专家精选No.25:小鹏“猫步”机器人出圈,PI发布最强VLA模型π*0.6,谷歌提出嵌套学习范式NL

发表日期: 2025年12月12日

1.小鹏“猫步”机器人IRON成功出圈,迈出“物理AI时代”关键一步

11月5日,小鹏发布了全新一代人形机器人IRON,以“猫步式”流畅步态亮相,引发了关于人形机器人技术进展的热烈讨论。

IRON采用了创新的骨骼-肌肉-皮肤三层递进架构,搭载了自研的图灵AI芯片,通过“VLT+VLA+VLM”的高阶大小脑组合,实现了从视觉信号到动作指令的端到端生成,使其反应速度和动作流畅度达到了新的高度,这一突破被定位为“物理AI时代”的开端。

针对通用人形机器人运动控制、环境认知、动作规划等挑战,近年来业内从改进硬件设备、创新算法和调整结构等角度提出了众多的解决思路:

灵巧操作方面,SanctuaryAI的指尖传感器,显著提升了机器人盲抓取和精细操作的能力;波士顿动力Atlas通过模块化末端设计,在特定场景下切换机械手与夹爪,兼顾灵活性和可靠性。

双足行走方面,特斯拉Optimus和宇树机器人,将强化学习(RL)技术引入动态平衡控制,通过模拟试错优化运动策略,提升了行走稳定性;为缓解关节冲击,增强动作安全性,NASA机器人Valkyrie和特斯拉Optimus还采用了柔性执行器和液压阻尼系统。

感知规划层面,星动纪元的具身大模型架构,通过“感知-决策-控制”的一体化,实现从高层指令到具体行动步骤的分解。

专家预测,未来人形机器人将专注于特定场景/任务(如仓储搬运、医疗辅助),其形态可能突破传统人形模板,在实践中不断优化,朝真正通用智能迈进。

链接:https://mp.weixin.qq.com/s/99GZYhV3l49-raMuh1i0QA

2.美国具身智能公司PI发布最强VLA模型π*0.6,任务成功率超90%

11月17日,美国具身智能公司Physical Intelligence(PI)发布了其最新的机器人通用基础模型π*0.6,显著提升了机器人在执行复杂任务中的鲁棒性和成功率。

π*0.6基于VLA(视觉-语言-动作)架构,通过大规模感知与动作数据训练,赋予了机器人适应复杂环境与任务的泛化能力。其核心创新在于引入Recap(基于优势条件策略的经验与纠错强化学习)方法,实现了机器人学习的三个关键步骤:模仿学习、纠正式指导和强化学习。相比传统监督学习,Recap解决了强化学习中的信用分配问题,通过训练价值函数,能够让机器人识别并强化有效动作,避免错误行为,从自身经验中不断优化,并快速适应不同任务条件。

通过离线强化学习预训练、示范数据微调以及真实环境中收集的经验训练,π*0.6在真实世界任务中表现出色,以超过90%的成功率完成多项复杂操作,包括组装纸箱的精细物理操作、应对多种布料特性的衣物折叠以及覆盖长操作序列的意式咖啡制作等,其吞吐量和效率均比早期版本提升两倍以上,满足了高效与高可靠性的实际应用需求。

作为通用机器人模型,π*0.6逐步摆脱了对人工示范数据的依赖,打破了以往训练速度与可靠性的瓶颈,为加速智能机器人在生产、服务等领域的普及奠定了重要基础。

链接:https://www.pi.website/blog/pistar06#where-are-we-headed

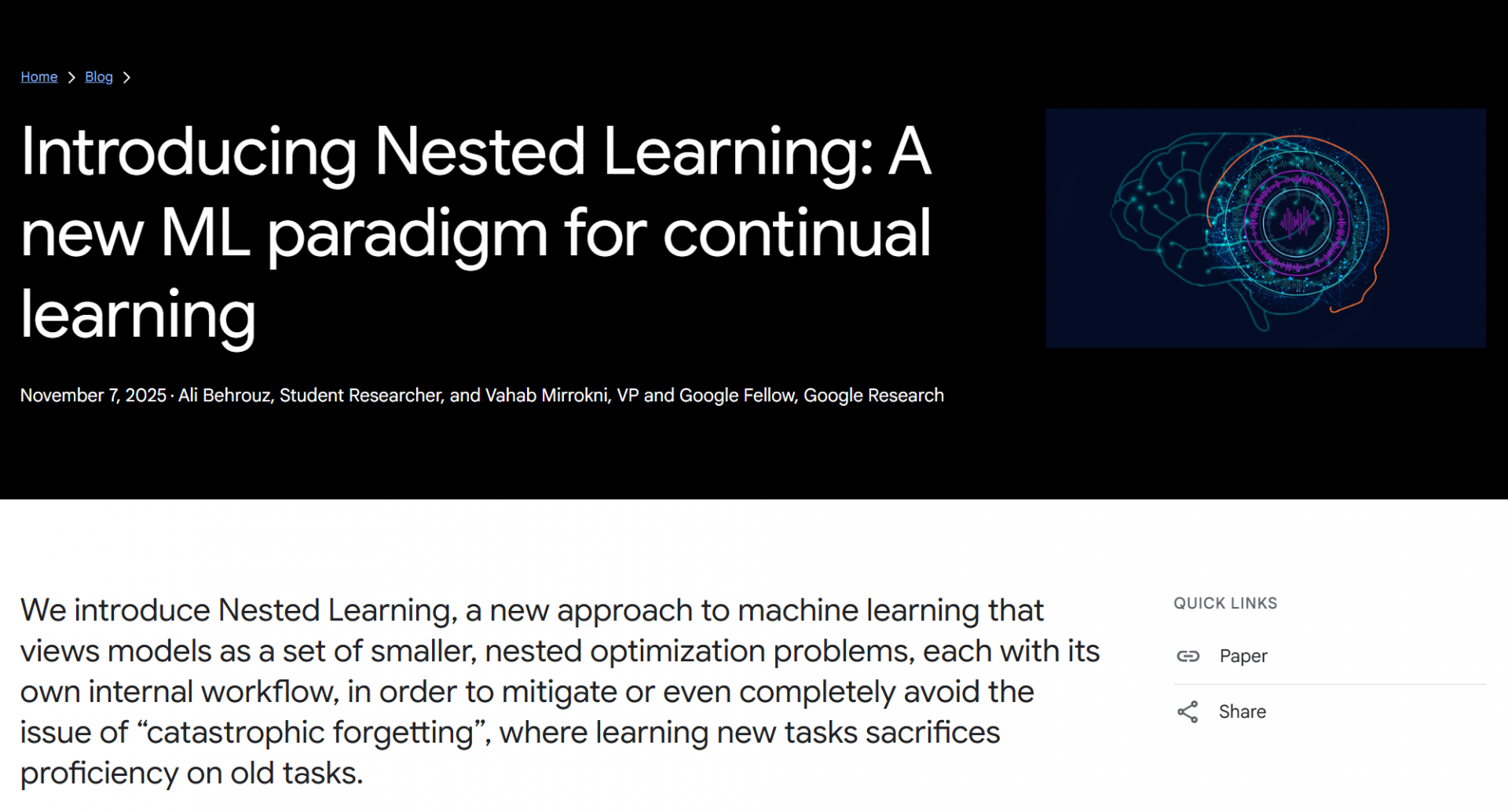

3.谷歌提出嵌套学习范式NL,引发LLM持续学习的新探索

11月7日,谷歌团队发文提出了一种面向持续学习的嵌套学习(Nested Learning,NL)范式,通过分层记忆与动态更新,实现知识的高效存储与检索,推动LLM从单一学习过程转向全面的记忆管理,为LLM的持续学习提供了新思路。

在LLM中,灾难性遗忘和动态环境适应是两大难题。NL的核心在于通过连续记忆系统(CMS)实现记忆管理,将模型视为层次化的嵌套问题,优化器被扩展为可学习的联想记忆模块,为不同层级配备独立存储。基于NL的HOPE架构在语言建模、长上下文推理等任务中表现优异,显著缓解了灾难性遗忘问题,展现了在记忆管理上的潜力。

除谷歌外,近期在记忆管理的创新探索中,Meta提出的稀疏记忆微调通过稀疏更新记忆槽,实现高效的参数精细化更新,显著缓解遗忘问题;俄亥俄大学和UIUC的Hippo RAG2则融合知识图谱构建与图搜索,模拟人类多跳推理能力,提升复杂任务性能;MIT和普林斯顿的TIM系统通过递归、分解式任务处理和KV缓存剪枝,实现了对长推理链的高效处理,突破了上下文窗口限制。

目前,持续学习的探索正从学习转向记忆管理,通过分层记忆机制、稀疏更新与动态推理优化模型的知识整合与保留能力,逐步弥合LLM与人类持续学习能力的差距。

链接:https://research.google/blog/introducing-nested-learning-a-new-ml-paradigm-for-continual-learning/

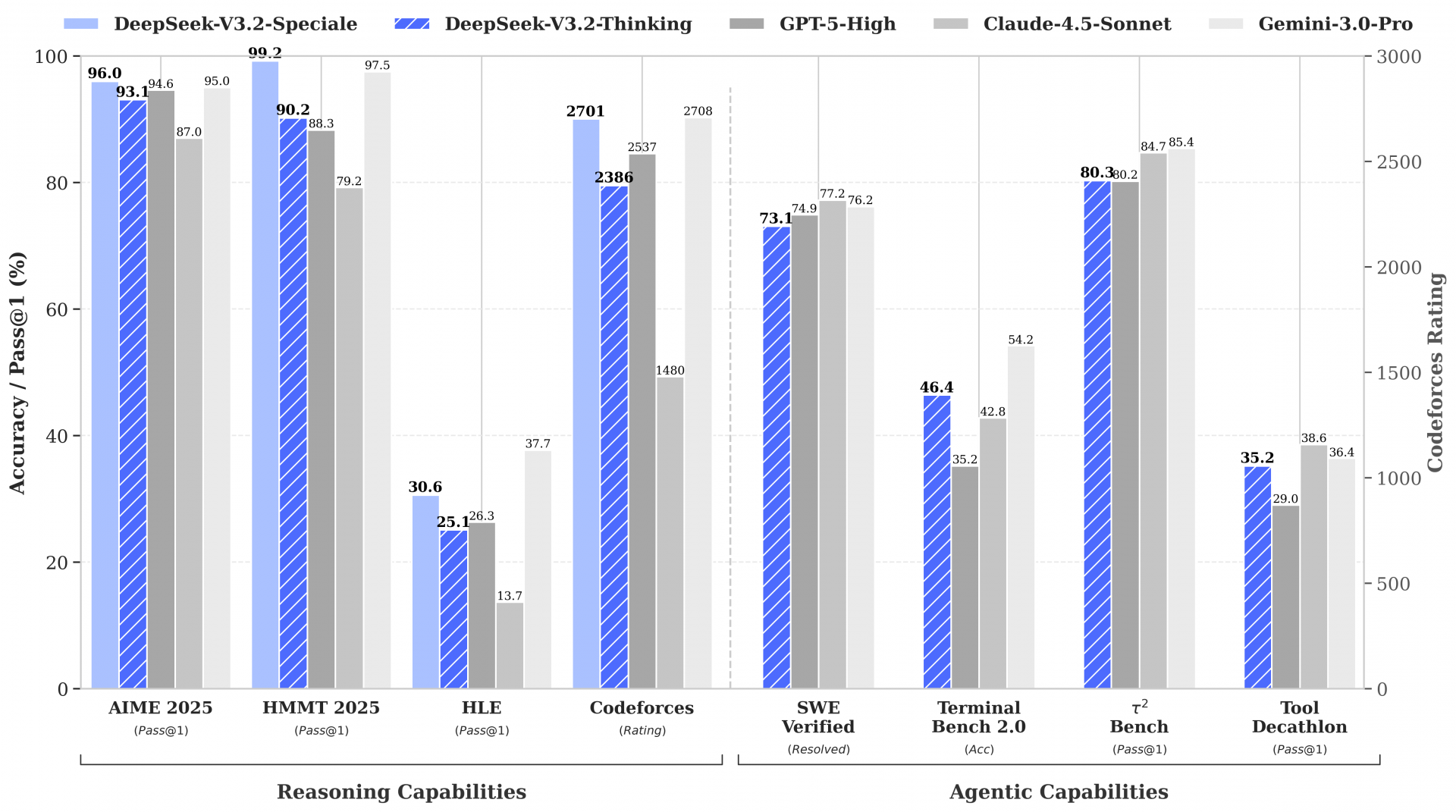

4.DeepSeek-V3.2系列开源,性能直接对标Gemini-3.0-Pro

12月1日,DeepSeek团队发布了两款重量级模型:DeepSeek-V3.2和DeepSeek-V3.2-Speciale,分别面向通用应用和高难度推理任务,技术性能和实际表现均达到业界领先水平。技术上,DeepSeek-V3.2创新主要包括:

DSA稀疏注意力机制:通过闪电索引器和细粒度token选择,优化长序列推理,降低成本的同时保证性能。

强化学习优化:投入超过预训练10%的计算预算,结合无偏KL估计、离线序列掩码等技术,大幅提升模型能力。

Agent任务突破:通过自动环境合成Pipeline和多领域专家蒸馏,模型在工具调用、代码Agent、搜索Agent等任务上展现了强大的泛化能力。

DeepSeek-V3.2专注于平衡推理能力与计算效率,是一款适用于日常问答、通用Agent任务及工具调用场景的模型。推理能力媲美GPT-5,同时在输出长度和计算开销上实现了显著优化。

评测数据显示,DeepSeek-V3.2在多项工具调用基准测试中超越现有开源模型,是当前开源领域内性能最优的通用模型。DeepSeek-V3.2-Speciale是V3.2的长思考增强版,专为高难度数学推理、逻辑验证和编程竞赛打造。其性能堪比Gemini-3.0-Pro,并在多项国际竞赛中展现了顶级水准。

DeepSeek-V3.2的发布,不仅通过架构创新有效降低了使用成本,还通过训练方法创新大幅提升了核心能力,为全球AI行业发展提供了清晰可行的下一代技术路径,标志着AI竞争正从“效果竞赛”转向“效率革命”。

链接:https://huggingface.co/deepseek-ai/DeepSeek-V3.2

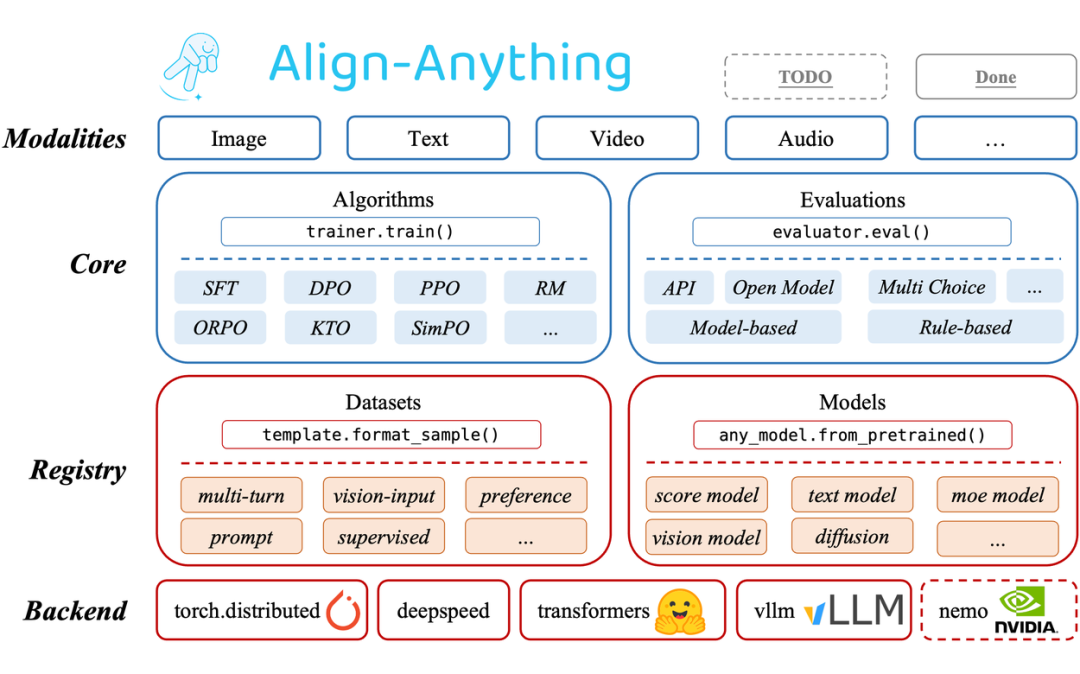

5.突破大模型对齐瓶颈,北大团队携手昇腾打通产业应用通路

近日,北京大学人工智能团队研发了一套覆盖全模态、兼顾高效率、赋能强推理的大模型对齐框架Align-Anything,并依托昇腾算力平台在智慧医疗、网络安全等多个关键领域实现规模化落地,展现了广阔的应用前景。

Align-Anything以“语言反馈”为核心,构建了一套覆盖文本、图像、音频、视频乃至动作的全模态对齐算法,解决了传统二元反馈信息量有限和一致性的问题。基于成熟的技术架构,团队在Align-Anything中集成专用评估工具Eval-Anything,可追踪并评估各类大参数模型在复杂任务中的真实能力,目前已实现开源。

在智慧医疗方面,Align-Anything充分发挥了昇腾软硬件平台的技术实力,构筑了全模态医学知识体系,支持图文、文表、图结构等多模态交互,赋能涵盖临床指征、心电图、超声心动图等全模态数据的高效训练。昇腾强大的异构计算能力与高内存带宽,可支撑大规模参数模型的高效并行训练。

在安全治理方面,Align-Anything通过与通用模型、安全评测平台及在线监控系统的模块化集成,能够自动对潜在风险回复进行识别、拦截与规范化重写,在显著提升整体安全水位、降低有害内容输出的同时,有效保持模型的通用能力与业务可用性。

Align-Anything框架的发布和广泛落地应用,不仅为学术界提供了可复用的基础工具,也通过昇腾算力实现了高性能与高效率的统一。

链接:https://align-anything.readthedocs.io/en/latest/

6.统一、高效、泛化:IEEE-TMI特刊揭示医学影像基础模型前沿

近日,IEEE-TMI特刊“医学影像基础模型进展”发布,系统总结了近年来医学影像基础模型的关键进展与发展趋势,全面展现了医学AI技术正迈向统一、高效、可泛化的系统化未来。

以分割为中心的基础模型:Swin-UMamba强化少标注条件下的高效分割能力;SFR通过拼接策略将SAM扩展至3D,显著提升Dice表现;SegAnyPath针对病理图像实现抗染色变化与跨尺度鲁棒性;On-the-Fly通过AuxOL机制融入专家纠正,贴近临床实际;UDEG-Net结合不确定性驱动的边缘提示与LoRA适配,提供稳健且可解释的预测。

多模态与视觉-语言集成:BrainCLIP将fMRI嵌入CLIP空间,实现零样本脑解码与视觉对齐;CP-CLIP通过核心-边缘原则改进图文对齐并定位病灶;Disease-informedVLM结合语境提示与原型学习,适配未见类别;HiCur-NPC以分层课程融合CT、MRI及内镜数据,支持鼻咽癌多任务分析;FM-APP通过fMRI到sMRI的知识迁移实现零样本表型预测;VLM-CPL以提示与特征一致性筛选伪标签,完成病理分类。

架构与训练创新:DenseFormer-MoE结合DenseCNN与专家混合模型,支撑多任务脑影像分析;EchoFM基于海量超声心动图视频数据,构建稳健心脏表征;GzPT融入人眼注视信息,早期对齐临床相关区域;Prompt-agent框架通过框与点提示,精细引导低计数PET重建。

基准、伦理与合成:PathBench覆盖块级与整张切片评测,揭示多模态大模型在病理图像理解中的短板;伦理综述全面审视基础模型的安全、隐私与公平问题,并提出缓解策略;ToPoFM利用拓扑约束生成细胞级病理图像,提升下游任务表现。

链接:https://ieeexplore.ieee.org/document/11218696

7.临床医生主导研发,同济大学开源通用医学基座模型Med-Go32B

11月18日,同济大学附属东方医院发布了通用医学基座模型“Med-Go32B”,完全开放了模型权重与完整工程代码,为专病专科模型与临床智能体的快速研发和应用下沉提供了有力支撑。

作为“科班出身”的AI助手,Med-Go由临床医生主导研发,其数据由医生定标准,数据治理、标注与质控由临床专家把关,融合了教材、指南与多源资料,对罕见病、边界病例做人工合成与针对性增强,补齐“少而缺”的短板。医生把诊疗规律提炼成可量化规则,工程团队把规则融入模型开发流程,实现了“医学逻辑”与“工程逻辑”的深度融合。

目前,Med-Go已嵌入东方医院的HIS系统,并在医联体单位中广泛应用,涵盖急诊、重症、教学查房等场景。它能够协助医生快速归纳病例、分析数据,帮助学生高效掌握知识,同时支持病历质控、用药提醒和慢病随访等基层场景。其强大的“长尾能力”使其既能应对疑难杂症,也能覆盖常见病的全医疗过程。医生反馈,Med-Go不仅拓展了诊疗思路,提升了效率,还帮助医生将更多精力专注于患者服务。

经过超6000本权威教材的学习和130万道医学题目测试,Med-Go知识储备已超越由多学科医生组成的团队。Med-Go在近20项医学评测中的表现稳健,中文场景优势明显,临床推理能力优异。

Med-Go为广大医疗机构提供了一个低门槛、高可靠性的公共基础平台,显著降低了二次开发成本,有力推动了医疗系统的智能化升级。

链接:https://news.tongji.edu.cn/info/1003/92770.htm